검색엔진에 사이트를 등록할 때 사이트맵, RSS, 로봇룰을 함께 적용하여 등록하는게 좋습니다. 그래야 검색엔진이 내 사이트의 구조를 정확하게 파악할 수 있으며 사이트에서 주기적으로 업데이트되는 콘텐츠 정보도 최대한 빠른 주기로 반영할 수 있기 때문입니다.

그럼 지금부터 검색엔진에 사이트맵, RSS, 로봇룰을 적용하는 방법을 알아보도록 하겠습니다.

혹시 사이트 등록을 아직도 안하셨나요?

1. 검색엔진에 사이트맵(sitemap)등록하기

사이트맵은 검색엔진에게 내 사이트 구조를 이해할 수 있도록 돕는 역할을 합니다. 검색엔진이 사이트를 크롤링 할 때 사이트맵을 참조하여 사이트의 구조를 파악할 수 있습니다.

사이트맵은 아래와 같이 XML형식의 파일 형태로 제출하셔야 합니다.

단일 URL 위치를 포함하는 기본적인 XML 사이트맵의 예

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<url>

<loc>http://www.example.com/foo.html</loc>

<lastmod>2018-06-04</lastmod>

</url>

</urlset>사이트맵(sitemap) 생성하기

사이트맵을 생성해 주는 사이트에 접속하여 간편하게 만들 수 있습니다.

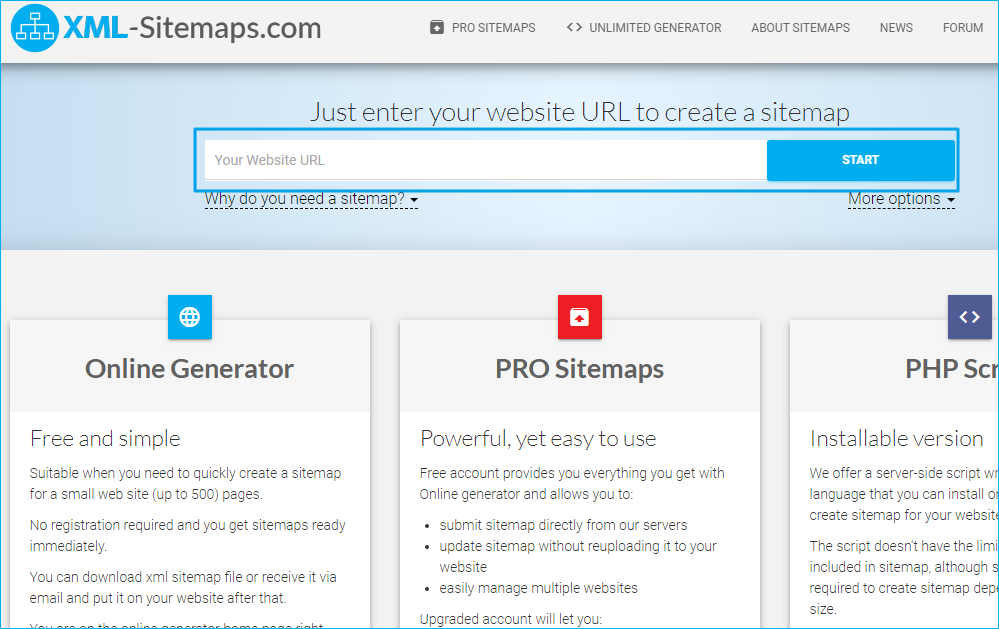

1) 사이트맵 사이트 접속 : https://www.xml-sitemaps.com/

2) 도메인 주소 입력

– 도메인 주소를 입력하고 START 버튼을 클릭합니다.

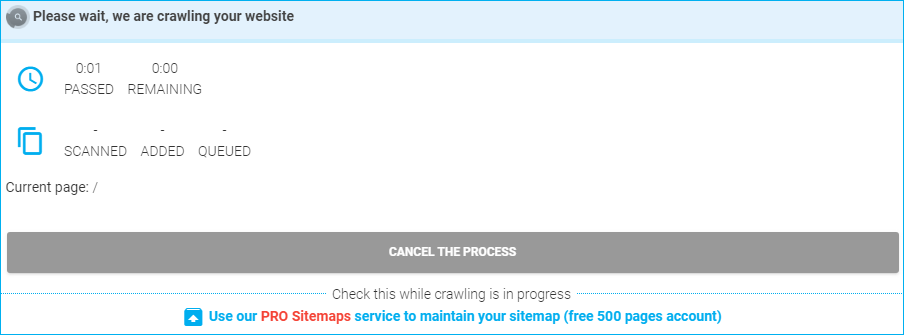

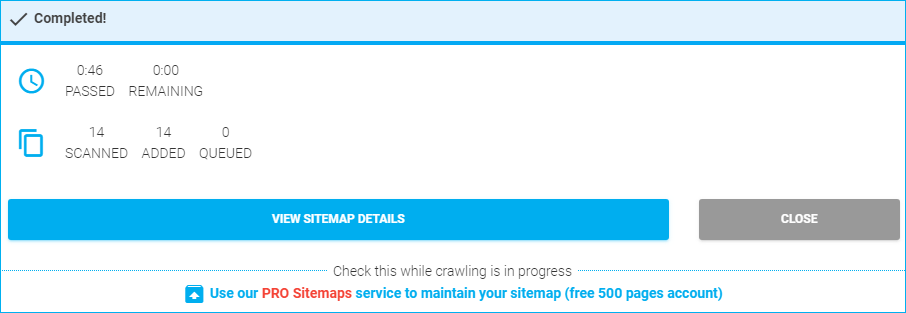

3) 파일 다운로드

– 사이트맵 생성이 완료되면 다운로드 버튼을 클릭하여 sitemap.xml 파일을 다운로드 받습니다.

4) 사이트맵 소스 보기

– 다운로드된 파일을 열어보면 아래와 같이 사이트맵이 정상적으로 수집된 것을 확인하실 수 있습니다. 저처럼 사이트 구조가 단순한 경우에는 사이트맵이 없더라도 검색엔진이 구조를 파악하는데 무리가 없겠지만 복잡한 구조를 갖고 있는 사이트라면 사이트맵은 꼭! 제출하시는게 좋습니다.

간단하게 아래 내용을 설명하자면

- <url> : <url>과 <url>사이에 하나의 메뉴를 작성한다.

- <loc> : 도메인의 전체 경로

- <lastmod> : 파일이나 소스의 최종 갱신일

- <priority> : 사이트 내 URL의 우선순위

예) 제1계층 1.0, 제2계층 0.8, 제3계층 0.5

<?xml version="1.0" encoding="UTF-8"?>

<urlset

xmlns="http://www.sitemaps.org/schemas/sitemap/0.9"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://www.sitemaps.org/schemas/sitemap/0.9

http://www.sitemaps.org/schemas/sitemap/0.9/sitemap.xsd">

<!-- created with Free Online Sitemap Generator www.xml-sitemaps.com -->

<url>

<loc>https://growthacking.kr/</loc>

<lastmod>2019-10-04T06:01:08+00:00</lastmod>

<priority>1.00</priority>

</url>

<url>

<loc>https://growthacking.kr/category/growthhacking/</loc>

<lastmod>2019-10-04T06:01:08+00:00</lastmod>

<priority>0.80</priority>

</url>

<url>

<loc>https://growthacking.kr/category/seo/</loc>

<lastmod>2019-10-04T06:01:08+00:00</lastmod>

<priority>0.80</priority>

</url>

<url>

<loc>https://growthacking.kr/category/analytics/</loc>

<lastmod>2019-10-04T06:01:08+00:00</lastmod>

<priority>0.80</priority>

</url>

</urlset>5) 사이트맵(sitemap) 업로드 하기

다운로드 받은 sitemap.xml 파일을 자신의 도메인 루트(root) 경로에 업로드 합니다.

만약 워드프레스를 사용하고 있다면 Yoast SEO 플러그인을 이용하여 사이트맵을 등록할 수 있습니다. 플러그인 설치 후 General의 Features 탭에 XML sitemaps가 있습니다. On으로 설정하면 사이트맵이 생성됩니다.

6) 사이트맵 확인 방법

- 일반 : 도메인주소/sitemap.xml 입력 시 sitemap이 열리면 정상적으로 업로드된 것입니다.

- 워드프레스 yoast 플러그인 사용 시 : 도메인주소/sitemap_index.xml 입력 시 sitemap페이지가 열리면 정상적으로 작성된 것입니다.

7) 검색엔진에 사이트맵 등록하기

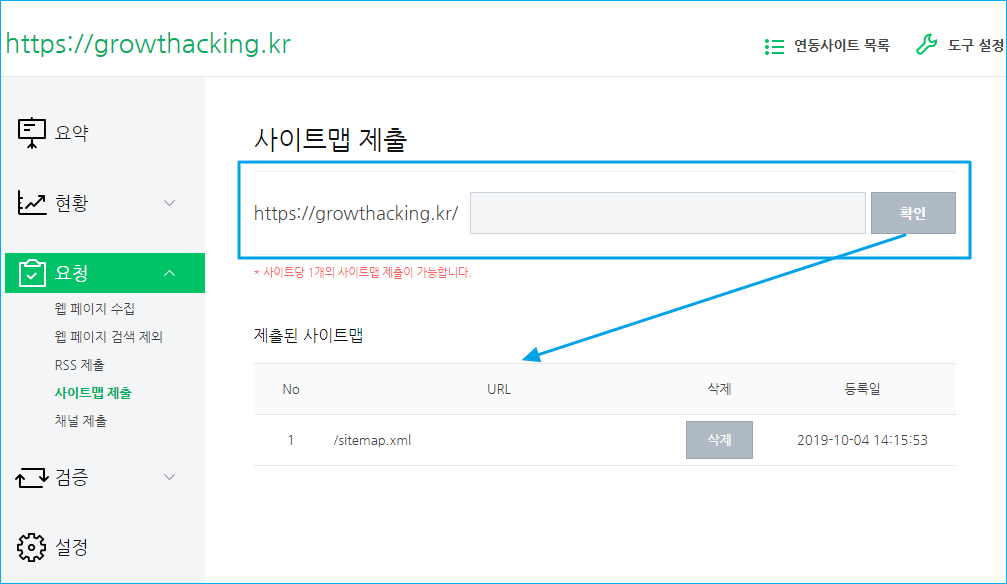

네이버에 사이트맵 등록하기

네이버 웹마스터 도구에 접속 후 도메인 선택 > 요청 >사이트맵 제출을 클릭합니다.

사이트맵 제출 입력란에 sitemap.xml을 입력하고 확인 버튼을 클릭합니다.

* sitemap.xml 파일은 자신의 사이트 루트 경로에 업로드가 되어있어야 합니다.

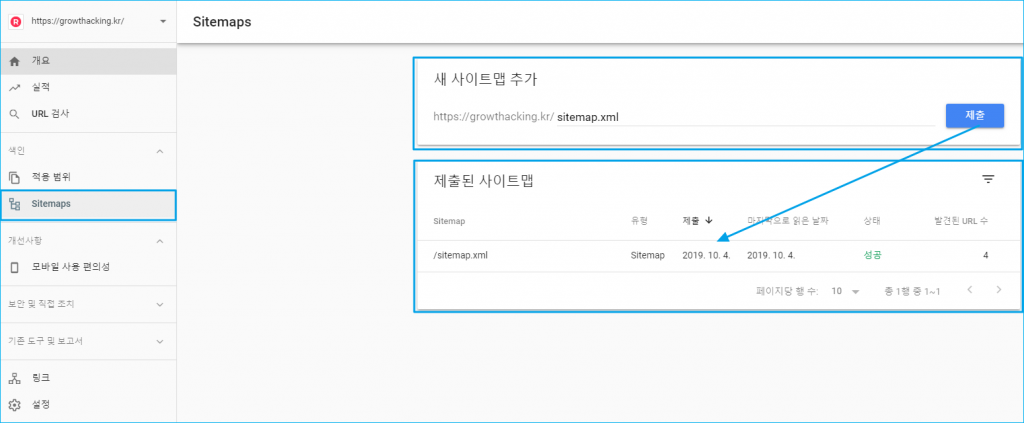

구글에 사이트맵 등록하기

구글 웹마스터 도구 에 접속 후 sitemaps 클릭 합니다.

사이트맵 제출 입력란에 sitemap.xml을 입력하고 제출 버튼을 클릭합니다.

2. 검색엔진에 RSS 등록하기

RSS(Rich site summary)는 업데이트가 빈번한 웹사이트의 정보를 사용자에게 보다 쉽게 제공하기 위하여 만들어진 XML 기반의 콘텐츠 배급 포맷을 말합니다.

검색엔진에 RSS를 등록해 놓으면 신규 콘텐츠가 업데이트되면 빠르게 검색엔진에 반영이되며 사용자 입장에서도 신규 콘텐츠가 업데이트되면 굳이 사이트에 방문하지 않아도 RSS 리더기 등을 활용하여 업데이트 정보를 확인할 수 있습니다.

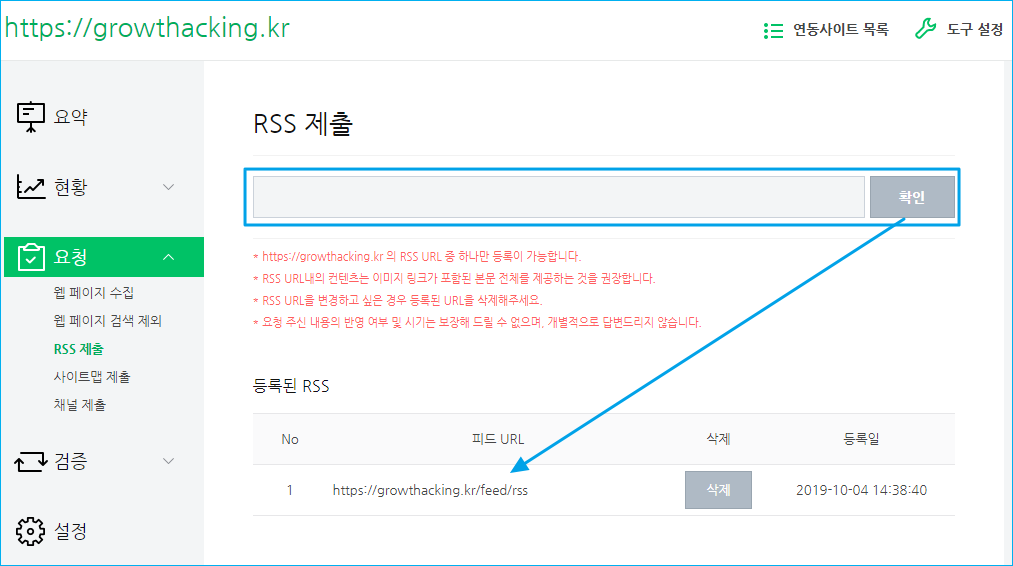

네이버에 RSS 등록하기

네이버 웹마스터 도구에 접속 후 도메인 선택 > 요청 >RSS 제출을 클릭합니다.

RSS 제출 입력란에 RSS 주소를 입력합니다.

* RSS는 도메인당 하나만 등록 가능합니다.

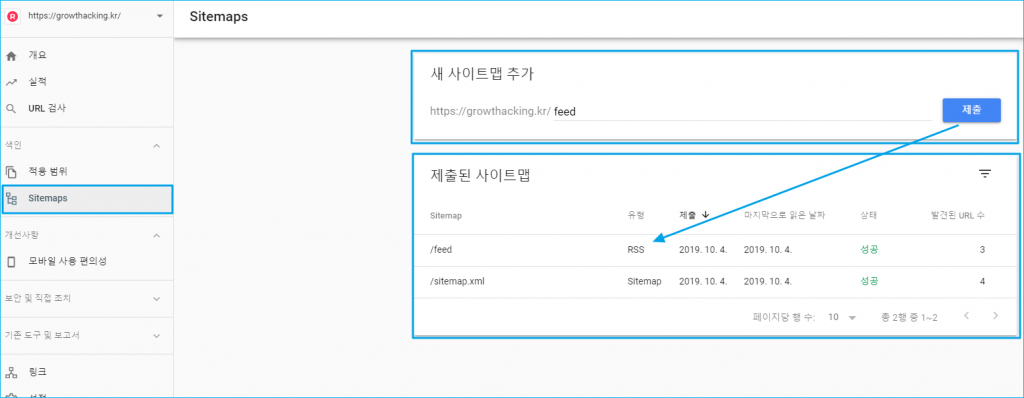

구글에 RSS 등록하기

구글에 RSS 등록하는 방법은 사이트맵 등록 방법과 동일합니다.

구글 웹마스터 도구 에 접속 후 sitemaps 클릭 합니다.

사이트맵 제출 입력란에 RSS 주소를 입력하고 제출 버튼을 클릭합니다.

(참고)

워드프레스 RSS 주소

– http://your-site-url/?feed=rss (기본주소사용 시)

– http://your-site-url/feed (그 외 주소 사용 시)

블로그 및 티스토리

– 블로그 및 티스토리 주소 /rss

* 도메인 주소 밑에 볼드 처리된 부분만 입력해 주시면 됩니다.

3. 사이트에 로봇룰 적용하기

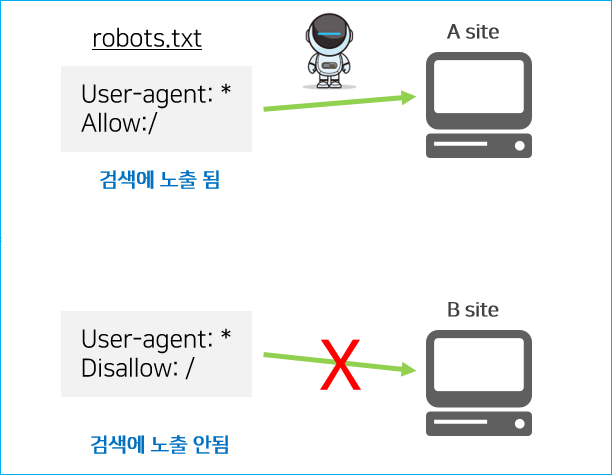

검색엔진은 크롤러(crawler)라는 소프트웨어를 통해 전세계의 사이트에 접근하여 정보를 수집하고 색인 작업을 합니다. 로봇룰은 웹사이트에 로봇이 접근하는 것을 방지하기 위한 규약으로 robots.txt에 기술하여 사이트에 적용합니다.

검색엔진의 크롤러가 사이트에 접속하면 일단 robots.txt가 있는지를 확인한 후 이 사이트에서 정보를 수집해도 되는지를 판단하게 됩니다.

하지만 robots.txt에 검색에 노출되지 않게 설정했다고 해서 내 사이트가 100% 노출 안되는건 아닙니다. 전세계적으로 수 없이 많은 검색엔진 봇이 존재하고 모두 로봇룰에 의해 크롤링을 하진 않습니다. 그리고 검색엔진의 봇은 사이트를 통해 이동하면서 정보를 수집하기 때문에 페이지로 바로 접근한 경우에는 로봇룰과 관계 없이 정보를 수집할 수 있습니다.

그래서 검색엔진의 크롤링을 완벽하게 막기 위해서는 메타 태그에도 인덱스 여부를 설정하는 것이 가장 확실한 방법입니다. 이 부분은 다음에 다뤄 보도록 하겠습니다.

로봇룰 예시

모든 로봇에게 문서 접근을 허락하려면, robots.txt에 다음과 같이 입력합니다.

User-agent: *

Allow: /모든 로봇을 차단하려면, robots.txt에 다음과 같이 입력합니다.

User-agent: *

Disallow: /모든 로봇에 admin 디렉터리 접근을 차단하려면, robots.txt에 다음과 같이 입력합니다.

User-agent: *

Disallow: /admin/구글 봇만 문서 접근을 허락한다면 robots.txt에 다음과 같이 입력합니다.

# 구글봇만 접근을 허용하며 mypage 디렉토리른 접근할 수 없다.

User-agent: googlebot

Disallow: /mypage/ 그 외 다양한 조합으로 로봇룰을 적용할 수 있으며 좀 더 자세한 정보를 robotstxt.org 사이트에서 확인하실 수 있습니다.